Les chatbots d’IA en psychothérapie : nouvelles lois restrictives aux États-Unis (2025)

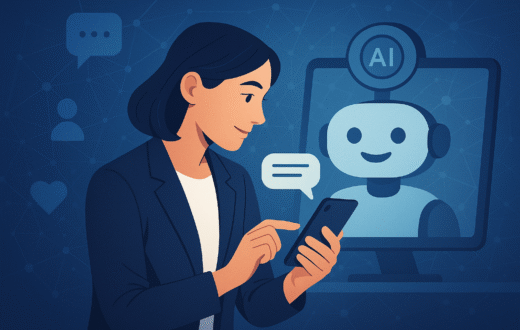

En 2025, trois États américains — Utah, Nevada et Illinois — ont adopté des lois limitant l’usage des chatbots basés sur l’intelligence artificielle dans les soins de santé mentale. Ces lois interdisent aux systèmes d’IA de fournir des diagnostics, des thérapies ou des décisions cliniques, mais autorisent leur utilisation pour des tâches administratives telles que la planification et la gestion des dossiers. Les restrictions sont entrées en vigueur le 7 mai en Utah, le 1er juillet au Nevada et le 4 août en Illinois. En Illinois, une amende pouvant atteindre 10 000 $ par infraction peut être appliquée.

Les législateurs invoquent la sécurité des patients et la nécessité de tracer une frontière claire entre outils administratifs et pratique clinique. Le Nevada interdit tout usage thérapeutique, tandis que l’Utah impose des exigences de transparence et de confidentialité afin d’empêcher l’IA de se faire passer pour des professionnels agréés. Ces mesures traduisent l’inquiétude croissante face aux risques d’outils non testés utilisés par des personnes vulnérables.

Opinions étudiantes et recherches

À l’Université Internationale de Floride (FIU), les professeurs Jessica Kizorek et Otis Kopp ont étudié les perceptions des étudiants. Beaucoup craignent que l’IA remplace des emplois et complique l’accès au marché du travail. D’autres redoutent une dépendance cognitive, notant que l’usage excessif réduit la capacité à penser de façon critique et résoudre des problèmes. Certains s’interrogent sur la meilleure façon d’intégrer l’IA sans en faire une béquille. Ces préoccupations rappellent le débat en santé mentale : l’IA n’a ni empathie ni responsabilité professionnelle, mais peut soutenir des activités comme l’écriture réflexive, la pleine conscience et la créativité.

Conséquences pour les universités

Ces lois influencent la formation académique. En Illinois et au Nevada, les étudiants en psychologie ne pourront pas expérimenter de chatbots thérapeutiques dans les cliniques universitaires. En Utah, une exploration encadrée reste possible, avec un accent sur l’éthique, la conformité et la régulation.

Les centres de conseil continuent de privilégier les services humains, bien que l’IA puisse encore aider en arrière-plan pour les formulaires d’accueil ou le tri initial. La question de la responsabilité légale demeure floue : si un étudiant utilise un chatbot de son propre chef, la responsabilité retombe généralement sur le développeur, sauf recommandation explicite d’un professionnel.

Perspective nationale

D’autres États comme le New Jersey, le Massachusetts et la Californie envisagent des mesures similaires. Au niveau fédéral, des agences comme la FDA pourraient instaurer une réglementation commune, mais le débat reste ouvert. Un projet de loi propose même d’empêcher les États de légiférer pendant dix ans, accentuant les tensions entre niveaux de gouvernement.

Conclusion

Ces lois ne rejettent pas la technologie, mais cherchent à définir sa place légitime. Aujourd’hui, l’IA reste limitée aux tâches administratives, à la recherche et à l’usage personnel, tandis que la thérapie demeure la responsabilité des cliniciens agréés. Pour les étudiants en psychologie, le choix de l’État d’étude influencera leur exposition à ces outils et leur apprentissage de l’équilibre entre innovation, régulation et soin humain.