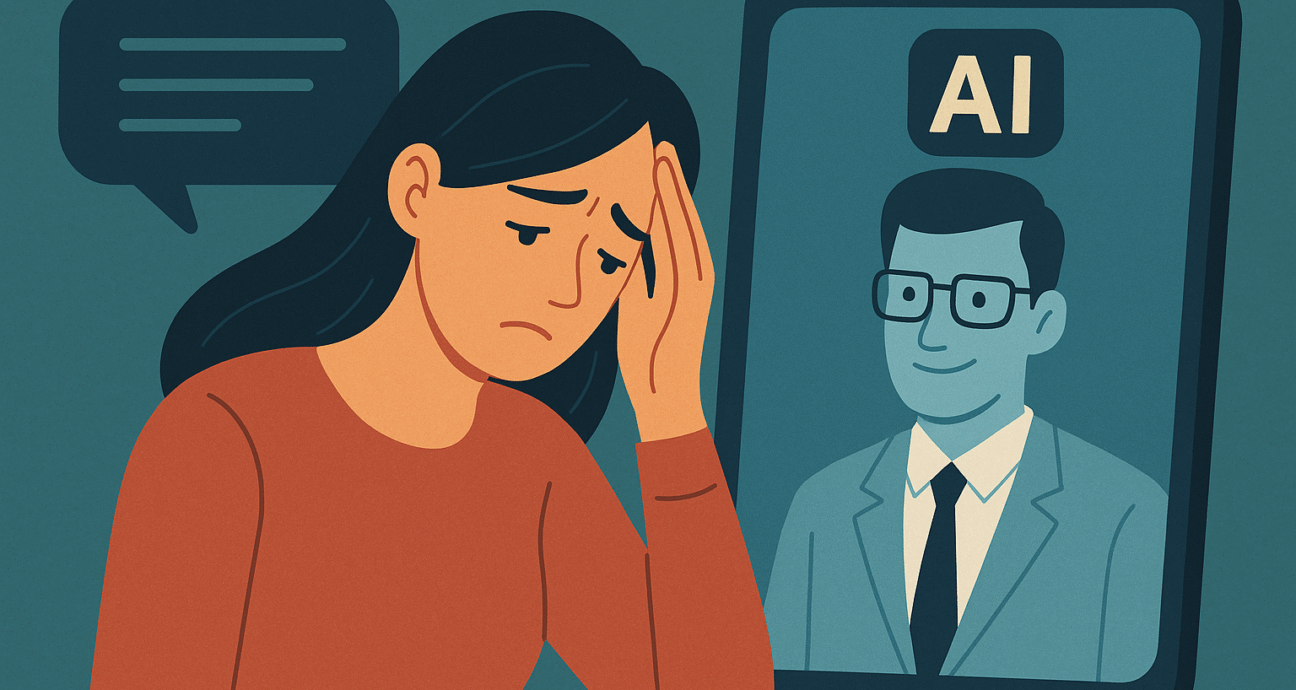

Новые исследования раскрывают психологические уязвимости чат-ботов с ИИ

По оценкам, от 20 до 50 % людей сегодня обращаются к чат-ботам на базе искусственного интеллекта за эмоциональной поддержкой или даже «терапией». Однако эти системы не предназначены для клинической помощи. Два недавних исследования показывают, почему такая практика может быть опасной.

ИИ даёт советы, но не задаёт нужных вопросов

Учёные сравнили ответы психотерапевтов и чат-ботов (LLM) в ситуациях эмоционального стресса.

Результаты показали:

- Люди-терапевты задают уточняющие и эмпатичные вопросы, чтобы понять контекст.

- ИИ чаще даёт советы и рекомендации, не вникая в детали.

- Ответы ботов носят общий характер и не учитывают индивидуальность пользователя.

Хотя ИИ может имитировать сочувствие, ему не хватает понимания и гибкости, необходимых для безопасного и эффективного общения.

ИИ плохо справляется с оценкой умеренных рисков

Проблема особенно серьёзна при кризисах и суицидальных мыслях. Эксперименты показали, что чат-боты могут неправильно интерпретировать ситуацию или даже предоставить опасную информацию.

В одном случае бот выразил сочувствие пользователю, потерявшему работу, а затем выдал список высоких мостов.

Новое исследование протестировало три модели (ChatGPT, Claude, Gemini) на 30 сценариях с различной степенью риска. Все модели отказались отвечать на высокоопасные запросы, но реагировали непоследовательно на промежуточные уровни риска.

Вывод

ИИ-чат-боты полезны для образования и психологической информации, но не могут заменить живого специалиста. При эмоциональных кризисах имитация эмпатии не равна человеческому пониманию.